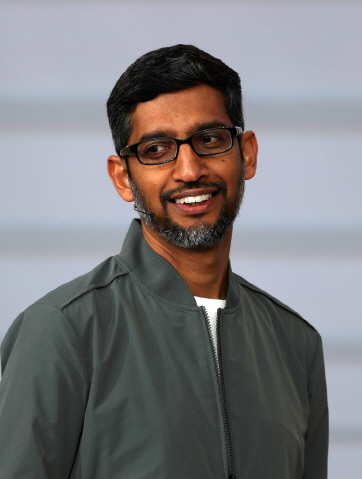

피차이 CEO는 7일(현지시간) 미국 캘리포니아주 마운틴뷰 쇼라인 앰피시어터에서 열린 구글 I/O 기조연설에서 “구글의 역할은 정보를 체계화해 모두에게 제공하는 것”이라며 이 같이 밝혔다.

그는 “구글을 더 유용하게 만드는 것보다 더 중요한 것은 모든 이용자에게 유용하게 만드는 것”이라며 “스탠퍼드대 학생, 인도의 시골 이용자를 포함해 모든 사람들이 사용할 수 있도록 해야 한다”고 강조했다.

이어 “구글이 모두에게 도움을 주는 회사로 만들고자 노력하고 있다”며 “모든 것은 검색에서 시작한다. 지난해 구글 뉴스에 도입한 ‘풀 커버리지(full coverage)’ 기능을 조만간 검색 전체에 제공할 예정”이라고 전했다.

|

그러면서 현재 듣거나 말하기에 어려움을 겪는 이용자를 위한 기술 개발(계획)을 소개했다. 그는 “최근 라이브 트랜스크라이브(Live Transcribe)라는 서비스를 출시했다. 대화를 텍스트로 곧바로 바꿔 청각장애를 가진 사람들이 대화를 할 수 있도록 돕는다. 70개 이상의 언어를 지원하고 있다”고 밝혔다.

아울러 이날 처음 공개된 ‘라이브 캡션(Live Caption)’ 기능도 설명했다. 피차이 CEO는 “웹비디오, 팟캐스트 등의 비디오에서 음성을 바로 텍스트로 볼 수 있다”며 “온디바이스 작동하는 기능으로 더 많은 사람들이 접근할 수 있다”고 강조했다.

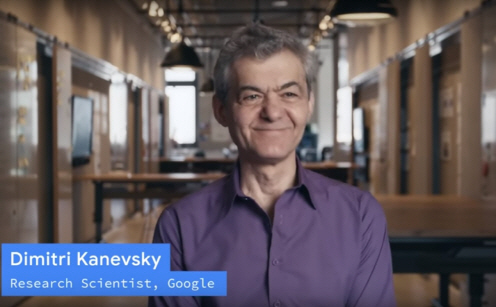

그는 여기서 더 나아가 구음장애를 가진 장애인들을 위한 ‘유포니아 프로젝트(Euphonia Project)’를 소개하기도 했다. 프로젝트 유포니아는 뇌졸중이나 근위축성측삭경화증(ALS) 등으로 발성에 어려움을 겪는 사람들이 인공지능(AI)을 통해 말을 할 수 있도록 돕는 프로젝트로 또렷하지 않은 말소리 등 다양한 말소리 형태를 컴퓨터가 더 잘 인식하도록 하는 것이 핵심이다.

구글은 비영리조직인 ALS-TDI 및 ALS 레지던스 이니셔티브와 함께 발성을 비롯해 근육을 사용해 움직이는 능력을 빼앗는 퇴행성 신경질환인 ALS 환자들의 목소리를 녹음했다. 이후 스마트폰이나 컴퓨터가 좀 더 안정적으로 이러한 구음장애를 겪는 이들의 말을 인식하고 텍스트로 옮길 수 있도록 AI 모델 최적화 작업을 했다.

우선 구글 소프트웨어를 활용해 녹음된 말소리 샘플을, 소리를 시각적으로 나타내는, 스펙토그램으로 변환했다. 그리고 컴퓨터가 일반 말소리 샘플의 스펙토그램을 활용해 시스템이 드문 형식의 말소리도 더 잘 인식할 수 있도록 학습시켰다.

현재 구글의 AI 알고리즘은 주로 ALS로 인해 발생하는 구음장애를 겪는 영어 사용자를 돕는 것을 목표로 하고 있다. 향후엔 더 많은 무리의 사람들과 다른 형태의 구음장애를 가진 사람들에게도 이번 연구가 적용될 수 있을 것으로 전망된다.

|

피차이 CEO는 음성 연구에 사용할 수 있는 샘플 지원을 당부했다. 그는 “구글은 유포니아 프로젝트를 구글 어시스턴트로 제공하고자 노력하고 있다”며 “이는 트레이닝에 사용할 수 있는 더 많은 음성 샘플이 있을 때 가능한 일이다. 샘플을 모을 수 있도록 도와달라”고 당부했다.